Neuerdings beantwortet die Google-Suche Wissensfragen häufig mit einer KI-generierten Antwort. Die klingt so stimmig, dass der Besuch von Webseiten gar nicht mehr nötig zu sein scheint. Und obwohl alle wissen, dass ChatGPT&Co. halluzinieren, überprüft hierzulande nur gut ein Viertel der Nutzer die Ergebnisse. Das ist fatal, denn falsche Antworten sind nicht etwa selten.

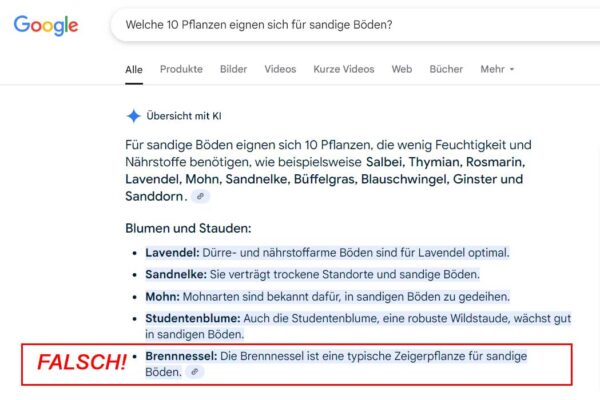

Hier ein Beispiel von heute, ich fragte Google: Welche 10 Pflanzen eignen sich für sandige Böden? So so! Wir haben sandigen Boden, aber Brennesseln wachsen nur rund um den Kompost, wo es schattig und der Boden äußerst nährstoffreich ist.

So so! Wir haben sandigen Boden, aber Brennesseln wachsen nur rund um den Kompost, wo es schattig und der Boden äußerst nährstoffreich ist.

Dass die Google-KI die Brennessel als „Zeigerpflanze für sandige Böden“ listet, könnte falscher garnicht sein! Es ist auf geradezu typische Weise falsch, denn in den als Quellen angegebenen Webseiten (die immerhin noch rechts von der Antwort angezeigt werden), handelt zwar eine Seite von Zeigerpflanzen, aber Brennessel wird dort korrekt als Anzeiger für stickstoffreiche Böden genannt. Google schüttelt sich da halt irgendwas „statistisch“ zusammen, wie es die „Large Language Modells (LLMs)“ nun mal recht häufig machen, die eigentlich zu Unrecht „KI“ genannt werden.

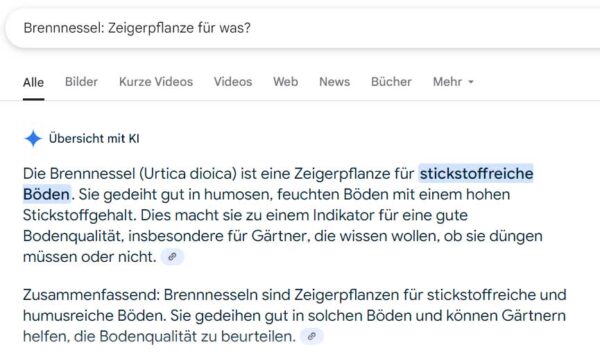

Frage ich speziell nach der Brennessel als Zeigerpflanze, antwortet Google richtig: Wer jetzt vermutet, ich hätte mehrere Testfragen gestellt, um ein falsches Ergebnis vorzeigen zu können, liegt falsch: Es war die allererste Testfrage, absichtlich zu einem Thema, über das ich schon viel weiß.

Wer jetzt vermutet, ich hätte mehrere Testfragen gestellt, um ein falsches Ergebnis vorzeigen zu können, liegt falsch: Es war die allererste Testfrage, absichtlich zu einem Thema, über das ich schon viel weiß.

Halluzinationen sind SEHR HÄUFIG!

Auch beruflich erstelle ich Texte über Pflanzen (Haus- und Gartenpflanzen, Pflegetipps etc.) und nutze zur Recherche durchaus KI, meist Perplexity, über das ich auch Zugriff auf Googles Gemini, Claude 3.7 und ChatGPT habe. Falsche Ergebnisse – mitten drin in den richtigen! – sind extrem häufig. Dass ich sie erkenne, liegt an wirklich langer Erfahrung mit der Recherche über Pflanzen aller Art und nicht zuletzt an 20 Jahren Gartenpraxis, eigene Zimmer- und Balkonpflanzen inklusive. Ich sag dann gerne mal „Prüfe das, das kann nicht stimmen!“. Das macht Perplexity dann auch und entschuldigt sich recht nett, wenn es – wieder mal! – voll daneben lag.

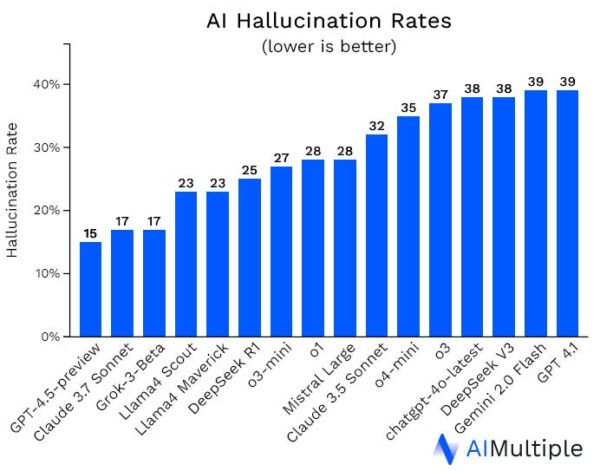

Hier seht Ihr eine aktuelle Statistik über die Häufigkeit von Halluzinationen (= netterer Begriff für SCHROTT!) quer über die verschiedenen KI/LLM-Modelle:

Bis zu 40 Prozent (!) falsche Ergebnisse sollten allen zu denken geben, die diesen Auswurf ungeprüft übernehmen, womöglich erneut auf Webseiten und Blogs veröffentlichen. Dort lesen die KIs das dann wieder zwecks „Schulung“ ein und die ganzen Unstimmigkeiten werden zur neuen „Wahrheit“. Ein Elend!

Wie seht Ihr das? Nutzt Ihr KIs und traut Ihr den Ergebnissen?

***

Siehe auch:

LLMs statt Links: Das offene Netz stirbt

„ChatGPT und AI Overviews lösen die Websuche ab. Das bedroht nicht nur Google, sondern auch viele Medien.“

23. Mai 2025 um 12:52

Hallo Claudia,

ja, das mit dem Halluzinieren ist unglaublich nervtötend – selbst wenn man in den Prompts ausdrücklich sagt, dass nicht halluziniert werden soll und stattdessen gesagt werden soll, wenn die KI etwas nicht beantworten kann, passiert es trotzdem… ich ärgere mich da regelmäßig mit herum, wenn ich KI beruflich für Anfragen wie „Liste die 10 relevantesten News der letzten 14 Tage aus den Bereichen X, Y und Z auf“ nutze. Selbst wenn ich explizit um die Nennung von Quellen bitte, fantasiert ChatGPT sich da irgendetwas zusammen – teilweise versucht er mir Meldungen unterzujubeln, die zwei Jahre alt sind, und die dazu angegebene URL sieht dann zwar erstmal richtig aus, existiert aber gar nicht auf der angegebenen Seite. Meckert man, entschuldigt sich die KI ganz blumig – und baut den nächsten Bockmist.

Ich nutze KI gerade mehr zum Geradeziehen von Formulierungen, gerade in anderen Sprachen… aber was Fakten angeht, trau ich dem kein bisschen über den Weg. Da bin ich schneller, wenn ich selber recherchiere.

Liebe Grüße

Anne

23. Mai 2025 um 17:34

Ich nutze KIs gerne, entweder für Grafiken oder auch mal für Texte. Als so eine Art Ideengeber, also als Werkzeugt. Dabei habe ich sehr schnell gelernt, prinzipiell nichts zu glaube, ohne eigene Recherche. Allerdings gilt das auch für normale Suchergebnisse bei Google. Denn auf den verlinkten Seiten kann genauso Unsinn stehen. Einer KI blind zu vertrauen, halte ich für sehr gefährlich.

23. Mai 2025 um 20:59

KI ist spannend und manches ist klasse:

Bilder generieren die unmöglich sind, wie fliegende Elefanten, Texte in sprachlich guter Qualität, Ideen, Anregungen…

Ich habe mal gefragt, was es über unsere Krone Randegg zu sagen gibt. Spannend war, dass wir ein Hotel-Restaurant betreiben mit sehr alter Tradition. Es stimmt, das Gebäude ist von 1774, wir haben jedoch kein Hotel, nur zwei kleine möblierte Projektwohnungen.

Das Restaurant mit Abendgeschäft, ist ein Bistrocafe, welches wir ausschließlich tagsüber betreiben, also eben kein klassisches Restaurant.

Am Ende kam noch der Nachsatz, man könne über den Kontakt auf der Webseite ja nochmal fragen um ganz sicher zu gehen.

Für mich daher weiterhin, als Inspiration, für manche klare Aufgabe ist KI ganz toll. Aber mal eben glauben, was die KI ausspuckt ist eine ganz schlechte Idee.

24. Mai 2025 um 16:35

Oh ja, ich habe KI auch schon sehr oft beim Halluzinieren erwischt. Das erzähle ich auch immer meinen Schülern, denen das aber wohl egal zu sein scheint. Neulich musste ich Audible-Guthaben eintauschen und wollte mir mal ein paar Hörbuchempfehlungen geben lassen. Ergebnis: 20% der Bücher gab es schlicht und einfach gar nicht. Da hatte sich ChatGTP einfach etwas ausgedacht, das mir gefallen könnte.

Ich nutze KI tatsächlich nur zum Brainstorming, zum Zusammenfassen von Texten für SEO, die ja eh keiner liest und zum Erstellen meines persönlichen Sportprogramms.

Was mir etwas Angst macht ist, dass die KI einem ja nach dem Mund redet, irgendwie hat man ja schon das Gefühl einen netten Gesprächspartner vor sich zu haben. Wenn ich mir dann vorstelle, dass diese KI uns alle indoktriniert und vor allem jene, die nicht wachsam sind…

Ich glaube das Thema ist eigentlich viel zu groß, als dass man es einfach mal so drauf ankommen lassen sollte…

Pingback: Kurzmeldungen aus der Blogpause › Digital Diary

Pingback: Something, something - Buddenbohm & Söhne

29. Mai 2025 um 12:11

Seit circa 2010 suche ich nicht mehr mit Google (wegen SEO und Google Adwords). Daher bin ich froh, wenn Google die eigene Dominanz auf dem Suchmaschinenmarkt dadurch bekämpft, dass es die Suchergebnisse mit aufgezwungener KI verschlechtert.

30. Mai 2025 um 13:35

Aus beruflichen Gründen beschäftige ich mich recht viel mit dem Thema und gerade für Recherchezwecke sind LLMs meiner Meinung nach nicht wirklich geeignet. Ausnahmen sind bestimmte, optimierte und trainierte RAG-Modelle mit eigener Datenbasis.

Oder wenn man Plexi fragt, wo man auf seinem Handy irgendwas einstellen kann. Da merkt man ja immer sofort, wenn es nicht stimmt.

Man darf niemals vergessen, dass LLMs *immer* „halluzinieren“ (ich würde den Begriff „Fabulieren“ vorziehen) – nur sagen sie dabei auch häufig die Wahrheit. Das ist einfach so und lässt sich auch nicht ändern. Alles, was man unternimmt, um das „Halluzinieren“ einzudämmen, sind Programmierarbeiten drumherum.

1. Juni 2025 um 14:36

Ich hatte vorgestern auch ein nettes Beispiel. Ich bin Pilzsachverständige kenne mich also generell ganz gut mit Pilzen im Allgemeinen aus (nicht nur Speisepilze). Eine Freundin sandte mir per WhatsApp das Bild eines Pilzes zu mit der Bitte um Bestimmung. Ich konnte den Pilz wegen schlechter Fotoqualität nicht erkennen und stellte das Bild dann (versehentlich) in meinen WhatsApp-Status mit der Bitte um Bestimmung. Eine Bekannte schickte mir dann eine Antwort von der Google KI, dass es sich wahrscheinlich um einen Riesenporling handelt, der jung essbar sei. Das ist komplett falsch und potentiell gefährlich, weil natürlich nicht klar ist, dass der abgebildete Pilz überhaupt essbar ist.

7. Juni 2025 um 15:24

Hallo Claudia, traue keiner KI voll und ganz. So sehe ich das auch! Danke für deine erhellende Ausführung…

Herzlich Angela vom Literaturgarten

27. Juni 2025 um 14:15

War neulich auch über eine KI-Antwort gestolpert, die meinte, Schimmel würde trockene Wände lieben. Da hab ich kurz gezuckt. Klar läuft da viel schief, aber komplett abschreiben will ich das Thema nicht, es ist halt ein Werkzeug, kein Orakel. Als wir nach einer neuen Lösung fürs Heizen gesucht haben, war so ein Mix aus menschlicher Beratung und digitalen Ideen jedenfalls ganz hilfreich.

29. Juni 2025 um 09:59

Neulich sah ich auf der re:publica einen spannenden Vortrag vom Netzlehrern. Der Fragte eine Bilder-KI, sie soll ihm mal Schüler:innen zeigen, die aus der Schule kommen – alle Ergebnisse zeigten traurige Kinder.

Die KI ist kein echtes Fact-Checking/Recherche-Tool. Sie ersetzt keine Suchmaschine. Sie gibt „Common-Sense“ wieder.

Sie kann fantastisch Coden – aber eine menschliche Qualitätssicherung ist unumgänglich.

Die KI greift ja quasi auch „nur“ auf den Quatsch zurück, den man oft im Netz findet. Bei mir wurde neulich ein Sommerflieder als naturnahe, insektenfreundliche Pflanzen angepriesen. Natürlich komplett falsch – aber wenn man sich die redaktionellen Beiträge von Gartenjournalen anschaut, die im Index hoch gerankt sind, dann weiß man, woher die KI ihre Falschinfos bezieht.

Die KI ist halt auch nur so klug, wie die Menschen, deren Daten sie verarbeitet. Oder?

Pingback: Brecht eine Lanze für das unabhängige Web – Clickomania

26. Juli 2025 um 23:55

Bei sandigem Boden denke ich auch nicht an Brennnesseln, da haben die Tools eindeutig Nachholbedarf. Trotzdem finde ich, dass KI bei grober Recherche helfen kann, solange man selbst noch den Kopf einschaltet.

Gerade beim Thema Gewächshaus-Ausstattung verlasse ich mich lieber auf fundierte Beratung und gute Planung statt auf wilde Vorschläge aus dem Netz. Was meinst du, wird sich die Qualität dieser Antworten jemals deutlich verbessern oder bleibt es bei einem digitalen Ratespiel?